La redondance et l’agrégation sont deux techniques essentielles en environnement SAN. La première technique vous donnera la continuité d’accès au stockage malgré la perte d’un élément du réseau tandis que la deuxième multipliera la vitesse des liens agrégés. Petit tour d’horizon…

Il existe plusieurs protocoles dans le monde des réseaux Ethernet comme le LACP (Link Aggregation Control Protocol – norme IEEE 802.3ad) et le Trunking qui peuvent grandement optimiser et sécuriser les environnements iSCSI au niveau des commutateurs. Les techniques comme MPIO (Multi Path I/O) et MCS (Multiple Connections per Session) s’occupent de rendre le stockage hautement disponible au niveau de l’initiateur.

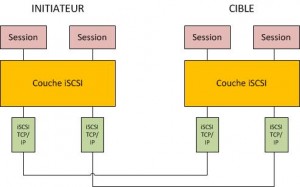

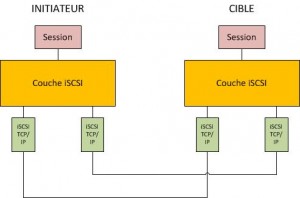

Le pilote MPIO de Microsoft autorise les initiateurs iSCSI d’ouvrir plusieurs sessions vers la même cible en la présentant de façon unique. Chaque session peut être établie en utilisant des cartes réseaux ou des commutateurs différents. En cas d’échec de l’une des sessions, les autres continuent de traiter les opérations d’entrée/sortie sans interruption. Cette technologie est la plus répandue à ce jour.

MCS fait partie intégrante du protocole iSCSI et permet l’agrégat de plusieurs connexions dans une seule session. Ainsi, les opérations d’entrée/sortie sont envoyées sur n’importe quelle connexion TCP/IP de la cible.

Pour conclure, MCS est le plus performant bien que ses avantages demeurent marginaux à l’heure actuelle et s’utilise lorsque MPIO n’est pas supporté (Windows XP, 2000 et Vista). MCS et MPIO agissent au niveau SCSI et ne peuvent pas partager une commande SCSI sur plusieurs liens mais permettent uniquement d’obtenir une redondance de liens. Il convient de mettre en œuvre les techniques de Trunking et de LACP en vue d’obtenir une augmentation des débits et une redondance sur plusieurs liens.

L’agrégation de liens permet à plusieurs liens distincts d’être vu comme un seul et même lien et permet d’obtenir une bande passante démultipliée mais aussi une redondance et une répartition de charge sur ce groupe de liens. Généralement le Trunking (configuration statique) est couplé à LACP.

Politique de répartition de charge

La répartition de charge MPIO (Multipath I/O) est destinée à accroitre la disponibilité des accès à stockage partagé en établissant plusieurs connexions, par l’intermédiaire d’un DSM (Device Specific Module). Ces modules peuvent être spécifiques selon les baies de stockage, EMC PowerPath et Infortrend EonPath ou encore un DSM Datacore pour les logiciels de virtualisation de stockage, sont quelques exemples.

Si vous désirez mettre en œuvre une architecture hautement disponible, il vous faudra impérativement doubler les équipements à tous les niveaux: cartes HBA, commutateurs, liens réseaux, contrôleurs actif/actif,…

Non seulement, le doublement de ces équipements vous permettra d’obtenir d’excellentes performances mais éliminera un éventuel SPOF (Single Point Of Failure – point unique de défaillance).

Selon l’hyperviseur, le DSM ou la baie de stockage, des politiques de répartition de charge différentes seront paramétrables. Voici celles que vous retrouverez le plus souvent:

- Fail Over (basculement uniquement): utilise un chemin d’accès actif et désigne tous les autres chemins d’accès comme étant en attente. En cas de défaillance du chemin d’accès actif, tous les chemins d’accès en attente sont essayés à tour de rôle

- Round Robin (répartition alternée): La stratégie de répartition alternée consiste à répartir uniformément les flux sur tous les chemins

- Round Robin with a subset of paths (répartition alternée avec sous-ensemble): La stratégie de répartition alternée avec sous-ensemble de chemins est similaire à Round Robin à la différence que l’on peut définir des chemins actifs et passifs

- Weighted Path (chemins d’accès mesurés): La stratégie des chemins d’accès mesurés prend en compte une charge de traitement spécifique relative à chaque chemin d’accès. Un nombre élevé représente une priorité faible du chemin d’accès

- Least Queue Depth (longueur minimale de la file d’attente: Uniquement supporté par MCS): La stratégie de longueur minimale de file d’attente compense les charges non uniformes en répartissant proportionnellement davantage de demandes d’entrée/sortie aux chemins d’accès de traitement les moins chargés

Après des tests intensifs, la politique la plus performante aussi bien en terme de débit que d’opérations d’entrée/sortie, est Round Robin with a subset of paths suivie de près par le Failover.